L’IA et le Cloud sont-ils les prémices de Skynet ou de 1984 ? !

Ces derniers mois, nous avons assisté à des développements significatifs dans le domaine de l’IA (Intelligence Artificielle) et ceci a généré des inquiétudes chez de multiples personnes, politiciens, scientifiques, … Tandis que certains voient dans l’IA une source d’émancipation pour les humains, qui pourraient être secondés, voire libérés dans de multiples tâches, d’autre entrevoient un futur sombre, où les machines pourraient prendre le pas sur les humains.

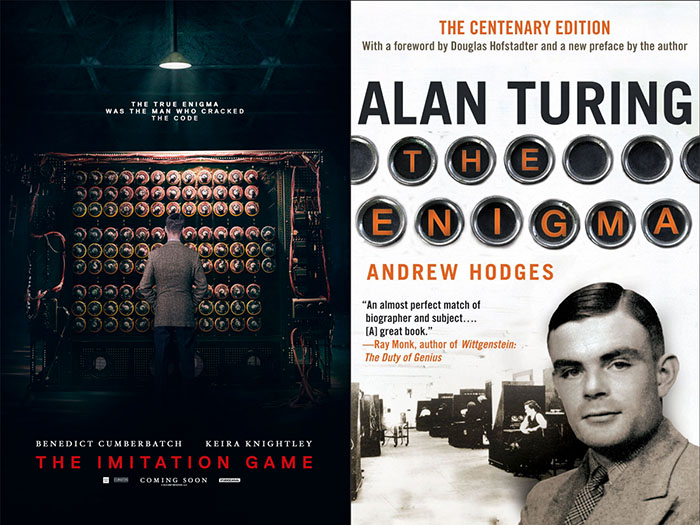

Sans entrer dans le débat philosophique de définir ce qu’est l’intelligence (même si cela est primordial), le concept d’IA n’a rien de nouveau. Son origine remonte aux années 50, lorsque Alan Turing a défini ce qui constitue l’informatique moderne. Il a été le premier à penser que les machines – que l’on n’appelait pas encore ordinateur à cette époque – serait de plus en plus performantes et potentiellement capable de se comporter comme un humain. Le Test de Turing compare la manière dont une machine interagit avec un humain avec la manière dont un humain le ferait. D’une manière simple, il décrit que si le testeur échange avec un interlocuteur à l’aveugle, et que ce testeur n’est pas capable de déterminer s’il interagit avec une machine ou avec un humain, alors on peut considérer la machine comme suffisamment évoluée, ou intelligente, pour se comporter comme un humain.

Bien que ce test soit resté célèbre en raison de la contribution primordiale de Turing à la science de l’information, il n’en reste pas moins un peu biaisé par sa vision anthropocentrique de l’intelligence et par l’association de l’intelligence avec le langage. Dans son roman « Les androïdes rêvent-ils de moutons électriques » (qui servit de base au film Blade Runner de Ridley Scott), Philip K. Dick pose de nombreuses bonnes questions et invente le test de Voight Kampff destiné à différencier les Réplicants des Humains.

L’objectif du test étant de déterminer la capacité de l’interlocuteur à éprouver de l’empathie, qui est donc selon K. Dick une caractéristique intrinsèque de l’humain, bien au-delà du langage, ou même de l’apparence dans le cas des Réplicants. Dans 2001 de Kubrick, HAL passerait probablement le Test de Turing si nous faisons abstraction de sa voix monocorde, mais certainement pas le Voight Kampff.

Une autre question fondamentale sous-jacente est la différence entre une Intelligence Artificielle et une Intelligence Humaine : Une machine est-elle capable d’intelligence ou bien seulement de simuler l’intelligence. En d’autres termes, l’intelligence humaine peut-elle se réduire à une suite de calculs ? Je n’ai pas la réponse, mais nous présentons tous qu’il y dans l’être humain plus qu’un algorithme. Une machine peut-elle avoir conscience qu’elle est une machine, peut-elle appréhender des concepts abstraits tels que la beauté, l’infini, la foi, la confiance, le sacrifice, l’amour, … ?

La simulation d’une intelligence à un niveau humain est restée une utopie pendant longtemps, et ce n’est que très récemment que l’accroissement colossal des puissances de calcul et des volumes de données nécessaires à alimenter les algorithmes a permis de faire des percées importantes. En 1997, la machine Deep Blue d’IBM a été le premier ordinateur capable de battre Gary Gasparov aux échecs. IBM avait créé une machine en mesure de battre le champion du monde, et donc potentiellement tous les humains à ce jeu. En 2011, IBM récidive avec Watson qui s’est montré plus fort que des humains au jeu télévisé Jeopardy ! Ces deux exploits ont été atteints avec des machines et logiciels dédiés pour ces tâches et un gros volume de données.

En 2017, Alphago de Google est devenu le premier logiciel capable de battre Ke Jie, alors champion du monde de Go. Le logiciel dans ce cas était basé sur du Machine Learning et du parcours de graphes alimentés par des données issues de parties de Go jouées par les meilleurs joueurs. Quelques temps après, Alphago Zero alla encore plus loin : Google se contenta de lui apprendre les règles du jeu, puis le laissa jouer contre lui-même jusqu’à ce qu’il s’améliore assez pour être plus fort que la précédente version d’Alphago, sans avoir même besoin de lui enseigner les méthodes de jeu des humains. Ce qui n’était qu’un rêve il y a 20 ans est devenu possible encore une fois avec la progression massive des capacités de calcul et de stockage disponible dans les Datacenters, qui permettent de faire fonctionner de tels algorithmes dans un délai raisonnable.

Pour en revenir au Test de Turing, dans tous les cas décrit, les joueurs humains savaient pertinemment qu’ils jouaient contre des machines, et les champions l’auraient probablement identifié également lors d’une partie à l’aveugle en raison de certains coups « surhumains » joués par les machines. Ne sous-estimons pas cependant ces performances, tant les jeux étaient considérés comme l’apanage des humains en raison des compétences particulières qu’ils requièrent : intelligence, expérience, créativité et même psychologie.

En mai 2018, Google fait une démonstration de Google Duplex en laissant la machine prendre un rendez-vous chez le coiffeur. Ceci peut paraître sommaire comparé à battre le champion du monde de Go, mais dans ce cas précis, l’interlocutrice humaine dans le salon de coiffure ne savait pas qu’elle conversait avec une machine et ne l’a visiblement pas soupçonné. Dans ce sens, Google Duplex a passé le Test de Turing et ceci a généré immédiatement une levée de boucliers de la part de multiples personnes. Le fait qu’une machine puisse se faire passer pour un humain était une ligne rouge qui a été franchie et beaucoup de gens ont entrevu les risques d’une telle technologie, au-delà des bénéfices éventuels. Encore une fois, cette performance a été réalisée avec du Deep Learning et un vaste volume de données pour imiter la voix et le comportement humain.

Bien sûr, l’IA n’est pas destinée uniquement à ce genre de spectacle. Son but est d’aider les humains et nous voyons déjà des applications pratiques dans de multiples domaines. Dans la santé par exemple, des IA peuvent aider les médecins à détecter des tumeurs dans les radios, ou bien aider au diagnostic. Beaucoup de questions restent à régler avec les voitures autonomes, mais cela pourrait potentiellement rendre le transport des personnes plus sûr.

Aider les humains est un objectif auquel tout le monde adhère, les remplacer est plus discutable. Les banques et les assurances commencent à remplacer des agents par des IAs. A l’heure actuelle, les Chatbots ne passent pas le Test de Turing, mais tout cela évolue vite. Ne soyons pas naïfs, des algorithmes sont déjà utilisés pour vous accorder un crédit ou calculer votre prime d’assurance. Dans quelle mesure pouvons-nous laisser les machines se mêler de la vie des humains ? N’y a-t-il pas un risque que les machines finissent par dicter leurs règles aux humains alors que cela devrait être l’inverse ?

En Juin 2018, Microsoft a immergé un Datacenter pour évaluer les gains potentiels au niveau de l’efficacité énergétique, mais également la capacité à déployer des machines partout où cela peut s’avérer nécessaire. Même si cette expérience ne concerne qu’un container, elle démontre également autre chose : ce container est auto suffisant et aucun humain n’y accèdera. Cette particularité permet à Microsoft de diminuer autant que possible le taux d’oxygène et d’humidité dans le container, et donc de limiter la corrosion qui est un problème pour les machines. Dans ce cas précis, le fait de supprimer l’interaction humaine permet d’augmenter la durée de vie des machines.

Si nous regardons maintenant un centre de logistique Amazon, tout est hautement automatisé, avec des robots qui transportent les produits à l’intérieur de l’entrepôt pour optimiser la livraison des commandes. Extrapolons ce concept dans un Datacenter et nous pouvons imaginer des robots déployant des serveurs, du stockage ou des équipements réseau. Poussons un peu la sophistication avec des robots plus agiles, capables d’enficher des câbles, de connecter les machines et de les démarrer. Ceci ne paraît pas si éloigné, en particulier pour les Datacenters hébergeant des Clouds, qui sont extrêmement industrialisés et homogènes. Il ne semble pas déraisonnable d’imaginer de larges Datacenters confinés et entièrement automatisés, où tous les déploiements seraient réalisés par des robots. Comme dans l’expérience de Microsoft, les conditions environnementales seraient mieux adaptées pour les machines et aucun humain n’aurait à pénétrer dans le bâtiment. Ajoutons une IA en charge du Datacenter et elle pourrait organiser le changement d’un équipement défectueux elle-même, voire une augmentation des capacités en fonction de la demande. Terminons avec la commande automatique d’équipements et vous aboutissez à un Datacenter physiquement « auto-scale ».

Nous ne sommes plus si loin d’un système autonome dans la gestion de ses ressources et capable d’augmenter sa propre capacité en fonction de ce qu’il décide, ou disons plutôt en fonction de ce que les humains auront initialement programmé. Se pourrait-il que ce système croisse et apprenne suffisamment pour considérer les humains comme inutiles dans l’équation ?

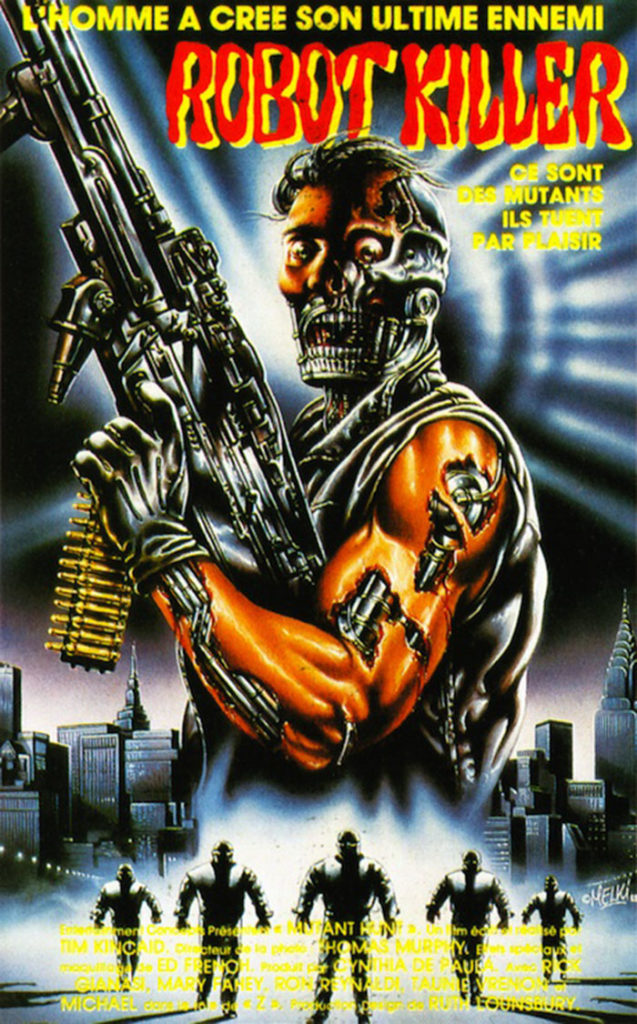

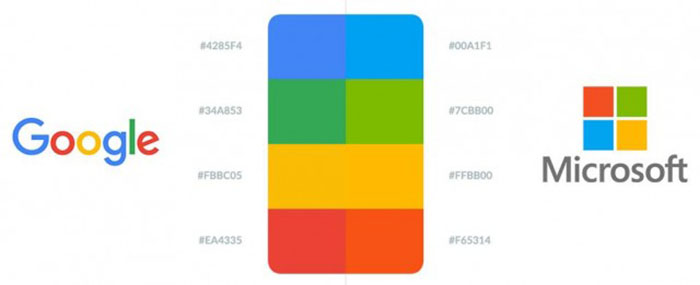

Ce n’est pas encore le Skynet de Terminator, bien sûr, et nous sommes loin d’une automatisation complète des chaînes de production des serveurs et de la logistique pour les délivrer au bon endroit. L’autre différence fondamentale est que Skynet est une « intelligence » unique dirigeant le monde, alors que nous voyons actuellement une rude concurrence entre de nombreux fournisseurs de Cloud. Il serait hasardeux de prédire aujourd’hui si l’un d’eux finira par dominer les autres. Les Leaders actuels du marché sont : Microsoft et Amazon, mais Google et IBM sont également dans la course.

Je ne sais pas à quoi ressemblera le futur et contrairement à Doc et Marty (Retour vers le futur) je ne dispose malheureusement pas d’une De Lorean disposant de 1.21 GW de puissance pour aller voir, mais si nous regardons un peu les écrits de Jules Verne et de nombreux autres auteurs, il est fascinant de constater combien de leurs prédictions se sont révélées clairvoyantes. L’entité numérique qui guide Neo dans Matrix ne s’appelle-t-elle pas Oracle ?

Revenons au présent : Nous voyons une adoption massive des services Cloud et une augmentation gigantesque du volume des données créées, stockées, analysées, ce qui nécessite des systèmes de plus en plus performants pour pouvoir prendre des décisions basées sur ces volumes colossaux de données. Peu de solutions totalement intégrées existent et les entreprises utilisatrices ont tendance à s’appuyer sur des fournisseurs multiples, qui doivent pouvoir être interconnectés entre eux et avec l’infrastructure en propre de l’entreprise, afin de bénéficier du meilleur des technologies actuellement disponibles. Réussir à interconnecter ces différents composants entre eux de manière efficace, afin qu’ils puissent partager des volumes de données énormes, nécessite de trouver un emplacement où ces données vont pouvoir être aussi proches que possible des différents systèmes et à les rendre accessibles avec un débit très élevé et un délai de transmission très réduit. Ceci n’est réalisable que dans des Datacenters ultra-connectés où tous les fournisseurs tels que AWS, Microsoft, Google, Oracle, IBM et bien d’autre encore sont disponibles et agrégés sur une plateforme unique.

Contrairement à Skynet, l’objectif de ces nouveaux services est de servir les humains et non pas de les asservir. Nous devons être prudents dans la manière dont toutes ces données peuvent être utilisées. Le scandale récent autour de Cambridge Analytica et Facebook montre que l’on peut agir sur des décisions humaines structurantes comme le choix d’un dirigeant en utilisant les données pour déterminer votre opinion politique. De plus en plus, tout ce que nous publions sur Web, ce que nous disons ou faisons est tracké, stocké, analysé. Facebook connait vos amis, probablement les membres de votre famille, ce que vous faîtes presque chaque jour, ce que vous aimez, ce qui vous intéresse, … Le travail de Cambridge Analytica a été d’utiliser toutes ces données pour définir votre profil, vos opinions et finalement, ce que vous pensez. Il est troublant est que cela ait fonctionné, remettant en cause notre libre arbitre, voire notre connaissance de nous-même.

Supposons maintenant que nous étendions ces processus à l’échelle d’un gouvernement et nous voilà très proches du monde décrit par George Orwell dans 1984, et il est peu probable que quiconque ait envie de vivre dans un tel endroit. Prenons conscience des informations que nous fournissons, car vous pouvez être certain qu’elles seront stockées et analysées pour enrichir votre profil numérique.

Les enceintes connectées telles qu’Alexa d’Amazon ou Google Home ou HomePod d’Apple sont des outils très utiles qui peuvent nous faciliter la vie, mais souhaitez-vous vraiment avoir dans votre maison un dispositif qui écoute en permanence ce qui s’y passe et analyse vos paroles et celles de toute votre famille ? Lisez ou relisez 1984 (qui soit dit en passant est l’année de sortie au cinéma de Terminator) et vous verrez à quel point c’est moderne. La seule chose qu’Orwell n’avait pas anticipé est que les gens ne seraient pas espionnés à leur insu, mais qu’ils partageraient délibérément tous les détails de leur vie sur les réseaux sociaux et paieraient pour avoir des dispositifs d’écoute chez eux. Présenté comme cela, c’est encore plus terrifiant, non ? Me revient à l’esprit « Ravage » de Barjavel !!!

Chronique : Guillaume Frémeau